Индексация сайта: статистика страниц в поиске, или почему поисковики игнорируют ваш сайт

Содержание:

- Как сделать так, чтобы Google индексировал обратные ссылки быстрее

- Как Яндекс и Google индексируют сайты?

- Рекомендации

- Почему не индексируется сайт

- С помощью сервисов

- Особенности индексирования сайтов с разными технологиями

- Популярные статьи

- Почему не индексируется сайт?

- «Яндекс» и Google не знает о вашем сайте

- Сайт или страницы закрыты от индексации в файле robots.txt

- Настройки приватности

- Сайт закрыт от поисковых роботов в мета-тегах

- Ошибки сканирования

- Сайт закрыт от роботов в .htaccess

- Нестабильная работа сервера или хостинга

- Проблемы с индексацией AJAX/JavaScript

- Дубли контента внутри сайта

- Плохая скорость загрузки

- Домен с баном

- Отсутствует sitemap

- Популярные проблемы с индексацией

- Этапы индексации сайта

- Почему не индексируется ресурс?

- Можно ли индексировать пустой сайт? Или сначала лучше наполнить его контентом?

- Почему индексация должна быть быстрой?

- Особенности индексации в ПС Яндекс и Google

- Как добавлять на индексацию в Гугле и Яндексе, и прочих ПС

- Чем отличается индексация в Google и Яндекс?

- Серпхант

Как сделать так, чтобы Google индексировал обратные ссылки быстрее

Волшебной кнопки для быстрой индексации в Гугле и других поисковиках не существует. Чтобы нажать её и бэклинки моментально попали в индекс. Но есть рекомендации, которые повышают шансы на успешное индексирование.

Окончательное решение остаётся за алгоритмами. Если они посчитают бэклинк подозрительным или у донора будут активные санкции, ссылки могут не появиться в консолях для вебмастеров.

Убедитесь, что сайт доступен для сканирования

Часто проблемы с индексированием связаны с тем, что роботы не могут получить содержимое страниц. Сайт недоступен из-за плохого хостинга, есть ошибки в конфигурационных файлах или неправильно настроен SEO-плагин.

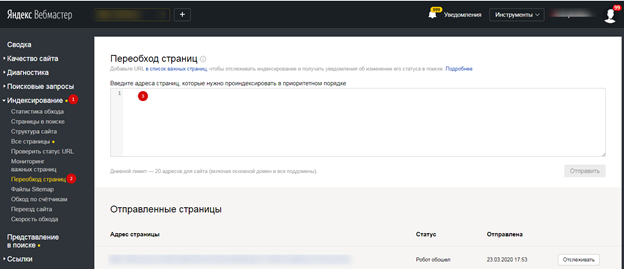

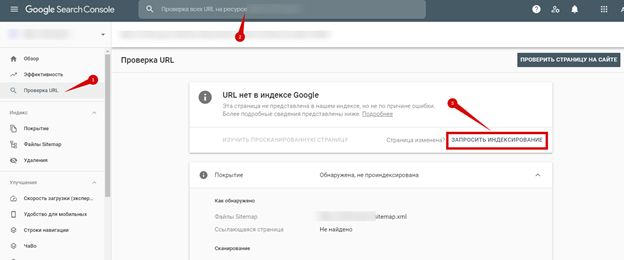

Самый простой способ проверить доступность для поисковых краулеров — использовать соответствующие инструменты в консолях для вебмастеров. «Переобход» в Яндекс.Вебмастер и «Проверка URL» в Google Search Console.

Добавьте сайт в Google Search Console

Для разбавления ссылочного профиля оптимизаторы часто размещают ссылки не только на старых сайтах, а и на новых проектах. Прежде чем переводить деньги за бэклинк, не забудьте проверить индексацию донора.

Сразу после добавления проекта в GSC, он становится в очередь и через некоторое время роботы обходят страницы. Обычно данные обновляются в течение пары дней, но иногда процесс может занять и недели.

Создайте файл Sitemap

Карта сайта сообщает роботам поисковиков, какие страницы надо обойти. Они считывают дату обновления из файла и понимают, что контент обновился. Если у донора нет карты сайта и новые статьи появляются нечасто, индексация бэклинка может затянуться.

Страница, на которой размещена обратная ссылка, обязательно должна присутствовать в Sitemap. Если вебмастер не следит за этим, проверьте файл и напишите ему с просьбой добавить страницу вручную или обновить список через плагин.

Проверьте robots.txt

Поисковые системы часто игнорируют директивы из технического файла, но иногда страницы с бэклинками не попадают в выдачу из-за ограничений в robots.txt. Гугл и Яндекс давно рекомендуют использовать meta robots, но некоторые вебмастера используют старые методы запрета индексации.

При размещении ссылок на сторонних сайтах доступа к консолям для вебмастеров нет, поэтому для проверки доступности страницы приходится использовать сторонние инструменты. Решить задачу можно с помощью Tools.discript.ru или аналога.

Мониторьте обратные ссылки вручную

При размещении бэклинков через ссылочные биржи можно отслеживать индексацию в одном интерфейсе. Если линк со временем отвалится или выпадет из индекса через несколько дней, можно заказать повторное размещение. Например, при заказе крауд ссылок через нашу биржу Referr, вы сразу в интерфейсе будете видеть новые ссылки и мониторить вручную, чтобы они были доступны.

При работе с вебмастерами напрямую приходится контролировать все самостоятельно. Владелец проекта получает деньги, размещает бэклинк и забывает о вашем существовании.

Усильте ссылки бэклинками

Чем больше упоминаний о важной странице с бэклинком, тем лучше. Тратить много денег на усиление чужого сайта не стоит, но несколько ссылок точно не помешают

В ваших интересах, чтобы инвестиции в линкбилдинг быстрее дали плоды.

Проставляйте линки на свежих страницах

При размещении ссылок через ссылочные биржи вебмастера часто размещают статьи оптимизаторов или заказывают свои. Не секрет, что такой контент очень низкого качества и бэклинки часто вставлены не по смыслу.

Старайтесь подбирать релевантные ресурсы и попросите владельца сайта разместить бэклинк на свежей странице. Или хотя бы немного изменить контент старой статьи и отправить её на переобход.

Проверьте наличие быстробота

У сайтов с новостным контентом и ресурсов, которые обновляются несколько раз в день, обычно нет проблем с индексацией. Ссылки с таких проектов поисковики быстро обнаруживают и если они пройдут проверку, бэклинки появятся в консолях.

Введите адрес сайта в поисковую выдачу, отфильтруйте результаты за день или неделю и посмотрите, как часто появляются новые страницы. Если на сайте есть «прикормленный» быстробот, на нем можно размещаться.

Как Яндекс и Google индексируют сайты?

Индексированием занимаются два типа роботов:

- Основные. Изучают контент, содержащийся на страницах интернет-ресурса;

- Быстрые (быстророботы). Анализируют и индексируют новые материалы, которые добавились после обновления сайта.

Чтобы веб-ресурс был проиндексирован в самых популярных поисковых системах, вебмастеру нужно сообщить о своем проекте:

- Добавить сайт на индексацию, самостоятельно заполнив специальную форму поисковика через такие сервисы, как Google Webmaster, Яндекс.Вебмастер и т.п. Такой способ индексации проходит медленно, от двух недель и дольше, потому что проект попадает в очередь.

- Отправить ресурс на индексацию посредством размещения ссылок на других веб-сайтах. Данный метод является самым эффективным, потому что найденные таким образом страницы боты считают полезными, и индексируют их куда быстрее – не более двух недель, а если повезет, то и вовсе за 12 часов.

В большинстве случаев, новые сайты и страницы индексируются за 1-2 недели. Многие отмечают, что поисковый гигант Google включает интернет-ресурсы в индекс гораздо быстрее, всего за несколько дней. Это связано с тем, что он индексирует страницы не только с качественным, но и плохим материалом. А вот под ранжирование попадает исключительно полезный контент.

У Яндекса подобный процесс проходит медленней, но под индексацию попадают только информативные и полезные страницы, а мусор отсеивается сразу.

Индексирование интернет сайтов проходит в 3 этапа:

- Робот отыскивает ресурс, изучает информацию, содержащуюся в нем.

- Добавляет найденный материал в базу данных.

- Спустя 1-2 недели информация, которая успешно прошла индексацию, попадает в выдачу поисковой системы.

Рекомендации

Не рекомендуется исключать фиды:

Потому что наличие открытых фидов требуется, например, для Яндекс Дзен, когда нужно подключить сайт к каналу (спасибо комментатору «Цифровой»). Возможно открытые фиды нужны где-то еще.

Фиды имеют свой формат в заголовках ответа, благодаря которому поисковики понимают что это не HTML страница, а фид и, очевидно, обрабатывают его иначе.

-

Прописывание Sitemap после каждого User-agent

Это делать не нужно. Один sitemap должен быть указан один раз в любом месте файла robots.txt. -

Закрыть папки wp-content, wp-includes, cache, plugins, themes

Это устаревшие требования. Однако подобные советы я находил даже в статье с пафосным названием «Самые правильный robots для WordPress 2018»! Для Яндекса и Google лучше будет их вообще не закрывать. Или закрывать «по умному», как это описано выше (Версия 2). -

Закрывать страницы тегов и категорий

Если ваш сайт действительно имеет такую структуру, что на этих страницах контент дублируется и в них нет особой ценности, то лучше закрыть. Однако нередко продвижение ресурса осуществляется в том числе за счет страниц категорий и тегирования. В этом случае можно потерять часть трафика -

Прописать Crawl-Delay

Модное правило. Однако его нужно указывать только тогда, когда действительно есть необходимость ограничить посещение роботами вашего сайта. Если сайт небольшой и посещения не создают значительной нагрузки на сервер, то ограничивать время «чтобы было» будет не самой разумной затеей. -

Ляпы

Некоторые правила я могу отнести только к категории «блогер не подумал». Например: Disallow: /20 — по такому правилу не только закроете все архивы, но и заодно все статьи о 20 способах или 200 советах, как сделать мир лучше

-

Закрывать от индексации страницы пагинации

Это делать не нужно. Для таких страниц настраивается тег , таким образом, такие страницы тоже посещаются роботом и на них учитываются расположенные товары/статьи, а также учитывается внутренняя ссылочная масса. -

Комментарии

Некоторые ребята советуют закрывать от индексирования комментарии и . -

Открыть папку uploads только для Googlebot-Image и YandexImages

User-agent: Googlebot-Image Allow: /wp-content/uploads/ User-agent: YandexImages Allow: /wp-content/uploads/

Совет достаточно сомнительный, т.к. для ранжирования страницы необходима информация о том, какие изображения и файлы на ней размещены.

Почему не индексируется сайт

1. Новый сайт. Иногда нужно просто подождать. Страницы в индекс не попадают все и сразу. Часто этот процесс растягивается на несколько месяцев.

2. Нет карты сайта (sitemap). Качественная карта сайта поможет поисковым роботам быстрее просканировать и проиндексировать ваш сайт. Ссылку на карту нужно добавить в панель вебмастеров и файл robots.txt.

3. Ошибки на сайте. Панели вебмастеров регулярно оповещают владельцев сайтов об ошибках. Заметили проблему в индексации? Смотрите, какие ошибки находит робот, и исправляйте их.

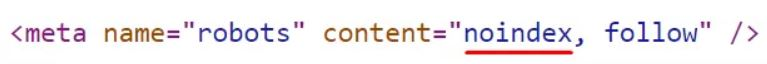

4. Ошибка с метатегом robots. Частая ошибка при несознательном изменении настроек CMS или хостинга. В коде страниц сайта появляется следующая строка:

5. Ошибка с X-Robot-Tag. X-Robots-Tag — HTTP-заголовок, но, в отличие от метатега robots, он находится не на странице, а непосредственно в файле конфигурации сервера. Вебмастера могут закрыть сайт, внося изменения или запуская тестовую версию, а потом забыть его удалить. Проверить, закрыт ли ваш сайт с помощью X-Robots-Tag, можно в Netpeak Spider или в консоли разработчика:

6. Ошибка с robots.txt. Часто советуют закрывать в robots.txt всё ненужное. Особенность файла robots.txt в том, что один лишний символ может открытый для сканирования сайт превратить в закрытый. Даже если вы правильно закрыли часть сайта, ненароком можно было зацепить нужные вещи, которые находятся глубже. Ваш сайт закрыт от сканирования, если вы видите у себя в robots.txt эту конструкцию:

User-agent: * Disallow: /

Что еще может стать поводом для проблем с индексацией сайта?

- дубли страниц;

- неуникальный контент;

- проблемы с доступностью и скоростью загрузки.

Читайте подробно, как ускорить загрузку сайта с помощью сервиса CDN.

С помощью сервисов

Сервисы — это менее точный метод, но его хорошо использовать, когда нужно проанализировать много сайтов.

Сервис Be1.ru

Вот так показывает индексацию сервис Be1

Как видно, сервис показал, что у меня недавно было прибавление страниц в Яндексе (и это соответствует реальности), а Google запаздывает.

Сервис Серпхант

Сервис предоставляет мощный функционал для SEO специалистов, но в данном случае нас интересует инструмент проверка индексации. Проверяет Яндекс и Google

Пример проверки индексации в Серпханте

Arsenkin

Cервис бесплатно проверяет индексацию в Яндексе, а для Гугл надо подключить базовый тариф.

Пример проверки индексации в Arsenkin

Promopult — платно, но дешево и много

Когда нужно проверить большее количество URL разом, то я использую сервис Promoputl. Проверка индексации в Яндекс и Google одной страницы стоит 2 копейки, отчет предоставляется в Excel

Проверка индексации от Promopult

Особенности индексирования сайтов с разными технологиями

Ajax

Сегодня все чаще встречаются JS-сайты с динамическим контентом ― они быстро загружаются и удобны для пользователей. Одно из основных отличий таких сайтов на AJAX — все содержимое подгружается одним сплошным скриптом, без разделения на страницы с URL. Вместо этого ― страницы с хештегом #, которые не индексируются поисковиками. Как следствие — вместо URL типа https://mywebsite.ru/#example поисковый робот обращается к https://mywebsite.ru. И так для каждого найденного URL с #.

В этом и кроется сложность для поисковых роботов, потому что они просто не могут «считать» весь контент сайта. Для поисковиков хороший сайт ― это текст, который они могут просканировать, а не интерактивное веб-приложение, которое игнорирует природу привычных нам веб-страниц с URL.

Буквально пять лет назад сеошники могли только мечтать о том, чтобы продвинуть такой сайт в поиске. Но все меняется. Уже сейчас в справочной информации и Google, и Яндекс есть данные о том, что нужно для индексации AJAX-сайтов и как избежать ошибок в этом процессе.

Сайты на AJAX с 2019 года рендерятся Google напрямую — это значит, что поисковые роботы сканируют и обрабатывают #! URL как есть, имитируя поведение человека. Поэтому вебмастерам больше не нужно прописывать HTML-версию страницы.

Но здесь важно проверить, не закрыты ли скрипты со стилями в вашем robots.txt. Если они закрыты, обязательно откройте их для индексирования поисковыми роботам

Для этого в robots.txt нужно добавить такие команды:

Поисковые роботы Яндекса тоже могут индексировать сайты на AJAX, но при одном условии ― если у каждой страницы сайта есть HTML-версия. В справочнике Яндекса можно узнать подробнее, как сообщить роботу об HTML-версии страницы.

Флеш-контент

С помощью технологии Flash, которая принадлежит компании Adobe, на страницах сайта можно создавать интерактивный контент с анимацией и звуком. За 20 лет своего развития у технологии было выявлено массу недостатков, включая большую нагрузку на процессор, ошибки в работе флеш-плеера и ошибки в индексировании контента поисковиками.

В 2019 году Google перестал индексировать флеш-контент, ознаменовав тем самым конец целой эпохи. Поисковые роботы Яндекса индексируют только тот текст во Flash-документах, который размещен в таких блоках: DefineText; DefineText2; DefineEditText; Metadata.

Поэтому не удивительно, что поисковики предлагают не использовать Flash на ваших сайтах. Если же дизайн сайта выполнен с применением этой технологии, сделайте и текстовую версию сайта. Она будет полезна как пользователям, у которых не установлена совсем или установлена устаревшая программа отображения Flash, пользователям мобильных устройств (они не отображают flash-контент), так и поисковым роботам Яндекса.

Фреймы

Фрейм это HTML-документ, который не содержит собственного контента, а состоит из разных областей ― каждая с отдельной веб-страницей. Также у него отсутствует элемент BODY.

Как результат, поисковым роботам просто негде искать полезный контент для сканирования. Страницы с фреймами индексируются очень медленно и с ошибками.

Вот что известно от самих поисковиков: Яндекс индексирует контент внутри тегов <frameset> и <frame> и не индексирует документы, подгружаемые в тег <iframe>. А вот Google может индексировать контент внутри встроенного фрейма iframe. Именно iframe поддерживается современными технологиями, так как он позволяет встраивать фреймы на страницы без применения тега <iframe>.

А вот теги <frame>, <noframes>, <frameset> устарели и уже не поддерживаются в HTML5, поэтому и не рекомендуется использовать их на сайтах. Ведь даже если страницы с фреймами будут проиндексированы, то трудностей в их продвижении вам все равно не избежать.

Популярные статьи

- 19 января 2021

- Продвижение

- 25K

- 17 мин.

План продвижения: как вывести свой бизнес в сеть и не запутаться?

С – Стратег! Составляем план по захвату мира продвижению своего бизнеса в сети.

- 14 марта 2020

- Продвижение

- 67.2K

- 8 мин.

Зачем вам нужен AMP Google? И нужен ли?

Google продолжает борьбу за улучшение мобильной поисковой выдачи. В продолжение mobile-friendly активно развивается проект AMP – так называемые «ускоренные мобильные страницы». Давайте посмотрим, как AMP будет помогать пользователям мобильных устройств, и, что еще важнее, сможет ли AMP помочь продвижению вашего сайта.

- 4 марта 2018

- Продвижение

Почему не индексируется сайт?

Бывают ситуации, когда вебмастер ведет работу над SEO-оптимизацией сайта: активно наполняет его контентом, наращивает ссылки, а количество страниц в поисковой выдаче Google или «Яндекс» не увеличивается. Или что еще хуже — в поиске нет ни одного документа с сайта. С чем это связано? Самые распространенные причины:

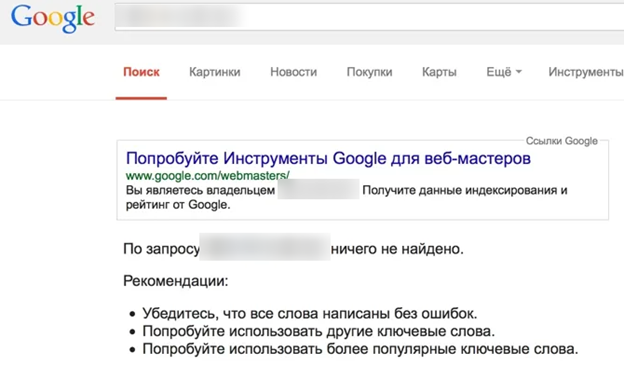

«Яндекс» и Google не знает о вашем сайте

Если это новый ресурс, и вы только недавно открыли его для поисковых роботов, то, возможно, они просто его еще не нашли. Но эту проблему легко решить, выполнив несколько простых манипуляций:

- Добавить сайт в «Яндекс.Вебмастер» и Google Webmasters.

- Направить поисковых роботов на страницы сайта.

В «Яндекс.Вебмастер» («Индексирование» — «Переобход страниц»):

В Google Webmasters («Проверить URL» — Добавить адрес страницы — «Запросить Индексирование»):

Нужно будет немного подождать, пока робот обойдет страницы сайта. Как правило, на это уходит 1-2 часа (хотя может затянуться на несколько дней).

Сайт или страницы закрыты от индексации в файле robots.txt

Порой вебмастера, работая над сайтом, забывают открыть его для индексации. Но это легко исправить. Добавьте следующую команду в файл:

Это означает, что ресурс открыт для всех поисковых роботов. Но не забывайте, что нужно закрыть дубли на сайте, ведь не все содержимое должно принимать участие в поиске. Поэтому уделите заполнению файла robots.txt достаточно времени.

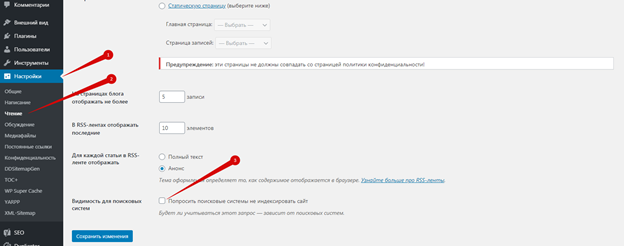

Настройки приватности

Если сайт управляется CMS WordPress, то по умолчанию в нем выставлены настройки приватности, которые запрещают индексацию поисковыми роботами. Авторизуйтесь в админке, перейдите в «Настройки — Чтение — Видимость для поисковых систем» и снимите галочку:

Сайт закрыт от поисковых роботов в мета-тегах

Запретить индексировать содержание страниц можно и с помощью мета-тега:

Как решить проблему:

- Посмотрите, нет ли такого тега на странице.

- Удалите код или добавьте другие мета-теги follow и index.

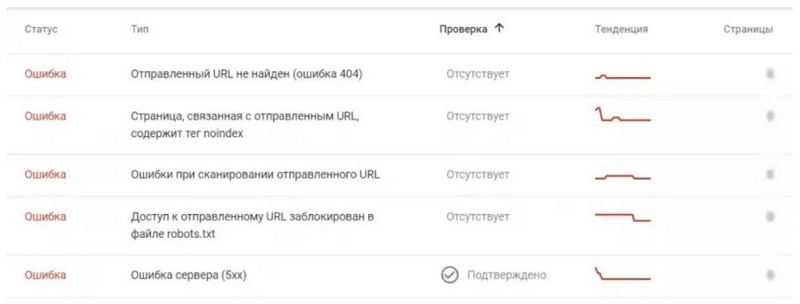

Ошибки сканирования

Проблемы с индексацией возникают и в том случае, если робот, обращаясь к ресурсу, не может просканировать его содержимое.

Проверьте все ли в порядке:

- Авторизуйтесь в Google Webmaster.

- Откройте «Сканирование» — «Ошибки сканирования»:

В идеале не должно быть никаких ошибок.

Сайт закрыт от роботов в .htaccess

В этом файле содержится правило 301 редиректа. Но помимо него, может быть прописана команда не индексировать сайт.

Чтобы проверить, выполните следующее:

- Найдите и откройте файл файл .htaccess на сервере.

- Проанализируйте содержимое кода.

Нестабильная работа сервера или хостинга

Выбирайте стабильный хостинг с хорошей репутацией. В противном случае, если роботы будут обращаться к сайту, он будет часто недоступен, а их попытки станут все реже. Через некоторое время они и вовсе откажутся заходить к вам на сайт.

Проблемы с индексацией AJAX/JavaScript

Поисковым роботам сложнее просканировать содержимое AJAX и JavaScript, чем HTML. Если вы допустите ошибки при оптимизации, то Google и «Яндекс» не проиндексируют определенные страницы или даже весь сайт.

Дубли контента внутри сайта

За дублирование контента поисковые системы наказывают санкциями, но это тоже одна из причин плохой индексации. К дублям может относиться одинаковый контент, открывающийся на разных страницах, мета-теги или даже страницы, если они доступны под двумя адресами (с www и без; http и https). Если не исправить проблему своевременно, то она негативно скажется на дальнейшем SEO-продвижении.

Плохая скорость загрузки

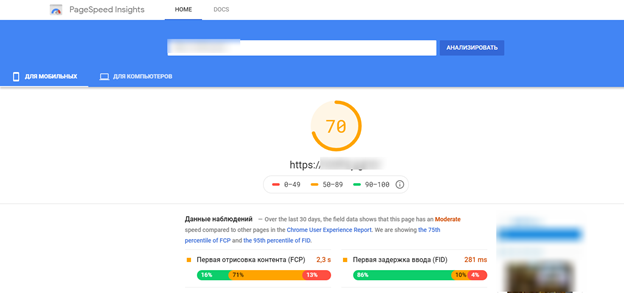

При плохой скорости загрузки ресурса, он может плохо индексироваться и потерять позиции, так как этот показатель относится к факторам ранжирования. Проверить насколько быстро загружается ваш сайт можно с помощью специального инструмента — Google Page Speed:

Поработайте над улучшением скорости загрузки сайта, учитывая рекомендации инструмента.

Домен с баном

Случается, что вебмастер выбирает и регистрирует созвучное имя для сайта, наполняет ресурс и ждет, когда он проиндексируется, но ничего не происходит. После анализа домена, выясняется, что домен ранее использовался и находится в бане поисковых систем.

Исправить такую ситуацию не просто. Придется написать в тех. поддержку «Яндекс», чтобы они пересмотрели ресурс или указали причину бана (если вы ее не знаете). Заниматься ли развитием сайта на этом домене — решать вам. Ориентируйтесь на то, что ответит вам техническая поддержка. Часто бывает проще начать все на новом домене.

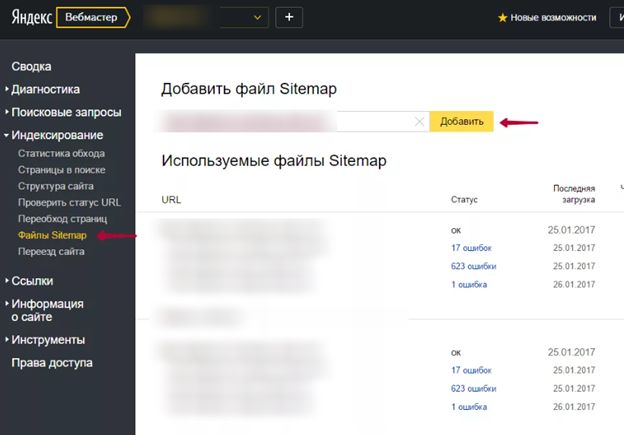

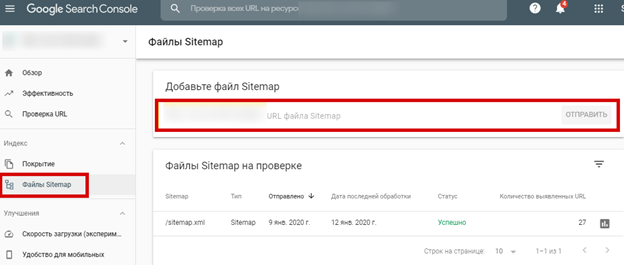

Отсутствует sitemap

Не самая распространенная причина плохой индексации, но не стоит ее исключать. Создайте карту сайта и не забудьте добавить ее в сервисы для вебмастеров от Google и «Яндекс»:

В «Гугл вебмастер»:

Популярные проблемы с индексацией

Когда мы знаем, сколько страниц от фактического количества проиндексированы, может быть 3 ситуации:

- Количество страниц в поисковиках и на сайте совпадает. Это идеальный вариант, значит с сайтом всё впорядке. Хотя все равно рекомендую проверить и сравнить.

- Количество проиндексированных страниц меньше. Значит с сайтом проблемы (наиболее популярная проблема — малоинформативный или неуникальный контент)

- Количество проиндексированных страниц больше. Скорей всего у вас проблема с дублированием страниц, т.е. одна страница может быть доступна по нескольким адресам. Это плохо для продвижения, т.к. статический вес страницы размывается и кроме-того получается много страниц с повторяющимся контентом.

Для дальнейшей диагностики сайта, нам понадобится узнать какие страницы точно проиндексированы, а какие не входят в индекс.

Этапы индексации сайта

У поисковиков есть специальные роботы, с помощью которых поисковые системы проводят индексацию.

У Яндекса есть основной робот, который скачивает документы для их последующей индексации, его еще могут называть «спайдер» (от spider — паук), есть отдельный робот для индексации изображений, робот-зеркальщик, который определяет зеркала сайтов, быстроробот (посещает часто обновляемые сайты и практически мгновенно помещает новые страницы в индекс, при этом на их ранжирование влияют не все факторы, и после захода основного бота позиции могут измениться).

Полный список роботов Яндекса можно найти (однако, там есть боты сервисов, которые уже закрыты, например, Яндекс.Каталог).

У Google тоже множество ботов: робот для сканирования новостей, изображений и видео, мобильных сайтов и т.д. Полный список поисковых роботов Google можно найти в справке.

Рассматривать работу всех ботов мы не будем, достаточно понять принцип:

- Поисковая система узнает о новом сайте,

- Основной бот заходит на сайт и скачивает основные страницы для дальнейшего анализа, вся информация помещается в отдельную промежуточную базу.

- Дальше в дело вступает робот «краулер» (от crawl — ползать). Он сканирует документы из временной базы и обрабатывает контент:

- Текст. Обработка текстового контента происходит в первую очередь. После изучения данные о нем передаются в очередь на добавление в основную базу поисковика.

- Скрипты. Если на странице таковые есть, то при первом посещении страницы они игнорируются. Если краулер сканирует данную страницу не первый раз, и основная информация уже была проиндексирована, то в этом случае поисковик может попытаться определить содержимое скриптов. Грубый пример: если текстовый контент транслируется на страницу через скрипты и поисковик сумел их извлечь, то эти тексты будут добавлены в базу.

- Ссылки. Если на страницах были найдены ссылки, еще не известные поиску, то информация о них передается основному боту и, как вы понимаете, процесс повторяется.

Это сильно упрощенная модель, но ее достаточно, чтобы понять, как все устроено.

Почему не индексируется ресурс?

Прошло недостаточно времени. Владельцам новых сайтов, нужно запастись терпением. Нередко попадание в индекс растягивается больше, чем на две недели.

Не добавлена карта сайта. Если вы решили проигнорировать sitemap.xml, возвращайтесь наверх и читайте, как это исправить.

Запрет на индексацию в файле robots.txt. Некоторые страницы сайта советуют закрывать от индексации. Это делают через прописывание специальных директив в служебном файле robots.txt. Здесь нужно быть предельно аккуратным. Лишний символ — и можно закрыть то, что должно быть доступным для поисковых роботов. В этом случае будут проблемы.

Ошибка с метатегом “robots”. Этот элемент кода сообщает поисковым краулерам о запрете на индексацию страницы. Он помещен между тегами <head> </head>, и выглядит следующим образом:

Метатег может появиться там, где не нужно. Часто это случается при изменении настроек движка или хостинга.

Запрет на индексацию в файле .htaccess. В этом файле прописаны правила работы сервера, и через него также можно закрыть сайт от индексирования.

Тег rel=”canonical”. Этот тег используют на страницах с дублированным содержимым, указывая с его помощью поисковым роботам адрес основного документа. Если страницы не попадают в индекс, причиной может быть наличие этого тега.

X‑Robots-Tag. В файле конфигурации сервера может быть прописана директива X Robots-Tag, запрещающая индексирование документов.

Долгий или неверный ответ сервера. Критически низкий отклик сервера создает сложности поисковым роботам при обходе сайта, из-за чего часть страниц может не залететь в индекс.

Некачественный контент на страницах. Плагиат, дубли, ссылочный переспам, автоматически сгенерированные тексты — все это также создает потенциальные риски.

Как видим, причин, по которым возможны проблемы с индексированием, довольно много. Но не переживайте, все это не нужно тестить вручную. Вебмастерки регулярно оповещают о возникших ошибках. Ваша задача — следить за уведомлениями в Яндекс.Вебмастере и Google Search Console и своевременно исправлять ошибки.

Можно ли индексировать пустой сайт? Или сначала лучше наполнить его контентом?

Мы отправили на индексацию не один десяток сайтов, и убедились, что особой разницы нет. Если сайт новый.

Вы можете сделать 5-10 стартовых страниц, наполнить их контентом и забросить сайт на индексацию. А можете добавить сайт пустым, и не спеша наполнять его контентом. Это не должно отразиться на скорости и качестве индексирования. Конечно, если не растягивать наполнение этих 5-10 страниц на месяцы. А вот с чем можно повременить на первых порах — оттачивание дизайна, создание перелинковки, размещение виджетов и пр. Это не так принципиально, если вы не планируете сразу же лить рекламный трафик на сайт.

Почему индексация должна быть быстрой?

Кроме увеличения трафика посетителей скорость индексирования влияет и на многие другие показатели ресурса.

Ежедневно в сети появляются новые сайты, тематика которых конкурирует с вашей веб-площадкой. Все они наполняются схожим контентом, который по мере роста численности конкурентов, теряет свою уникальность. Это происходит оттого, что большинство сайтов занимается публикацией многочисленных рерайтов. Простым языком, если вы написали уникальную статью и сразу не позаботились о ее учете поисковиком, не факт, что в момент такового материал останется уникальным.

Кроме того, не проиндексированный контент становится лакомой мишенью для мошенников. Недобросовестному веб-мастеру ничего не мешает попросту скопировать материал на свой ресурс, провести быстрое индексирование и получить от поисковых роботов право на его авторство. А вашу статью поисковики в дальнейшем сочтут не уникальной, что может привести к бану интернет-площадки

Поэтому контролировать и ускорять процесс индексации особенно важно для молодых ресурсов, пробивающих себе дорогу

Еще одним моментом, зависящим от быстрого индексирования каждой страницы, является возможность получать деньги за платные ссылки. Ведь до тех пор, пока статья с ссылкой не будет проиндексирована поисковиками, свое вознаграждение вы не получите.

Особенности индексации в ПС Яндекс и Google

Google и Яндекс — самые популярные поисковые системы у пользователей Рунета. Чтобы ресурс принимал участие в поиске, расскажите о нем ботам. «Пригласить» их на сайт можно следующими способами:

- Добавить сайт в «Яндекс.Вебмастер» и Google Webmasters. После чего робот обязательно посетит ресурс и вскоре его страницы проиндексируются.

- Проставить внешние ссылки на сайт с других ресурсов — страницы, которые были найдены таким способом, считаются полезными. Робот переходит по ним, передает вашему сайту определенный вес, одновременно индексируя его страницы.

В среднем на сканирование новых сайтов уходит от одной до двух недель. Но вебмастера отмечают, что индексация в Google быстрее. Все потому, что роботы сканируют все страницы: и качественные, и не очень. Но в поиск попадают только полезные материалы.

Пауки Яндекса работают в этом плане медленнее, но недостаточно качественные страницы не участвуют в поиске, так как их анализ происходит прямо на этапе индексирования.

Как индексируется сайт:

- поисковый бот заходит и анализирует контент;

- содержимое добавляется в БД;

- через некоторое время (до 2-х недель) проиндексированный документ участвует в поиске.

Как добавлять на индексацию в Гугле и Яндексе, и прочих ПС

Сейчас мы займемся рассмотрением вопроса добавления нового ресурса во всевозможные поисковики. Разберем наиболее популярные системы.

Яндекс добавить сайт на индексацию

Для добавления проекта на Яндекс портал поисковую систему необходимо перейти к форме добавления, в простонародье аддурилка. Располагается по адресу: http://webmaster.yandex.ru/addurl.xml

В открывшейся форме следует указать УРЛ адрес главной страницы добавляемого сайта и ввести капчу. После нажатия кнопки «Добавить» произойдет следующее:

-

Выскочит сообщение «ваш сайт добавлен» — это значит, что все в порядке, ресурс поставлен в очередь на индексацию в яндексе;

-

Появится сообщение «Ваш хостинг не отвечает» — это означает, что проблема с сервером, а точнее он прилег отдохнуть в тот момент;

-

Выскочила надпись «указанный URL запрещен к индексации» — можно начинать паниковать. На домен были наложены санкции, в результате чего он оказался забаненым. В таком случае, придется списываться с техподдержкой Яндекса и пытаться выяснять, как выходить из сложившегося положения.

Отправить сайт на индексацию Google

Добавление сайта в Гугл поисковую систему проходит точно так же как и в Yandex. Google имеет свою аддурилку, что находится по адресу: https://www.google.com/webmasters/tools/submit-url.

От капчи Вам и тут никуда не деться, правда, имеется пара отличий. В яндексе не обязательно иметь свой аккаунт, чтобы добавить url, а вот в Гугле Вы должны быть залогинены в свою учетную запись. И второй момент – это скорость: индексация в гугле происходит быстрее.

Индексация сайта в Рамблере

Хоть Рамблер информационно-поисковая система уже не представляет собой того гиганта поиска как раньше, но небольшой трафик с него все же идет, так зачем им пренебрегать. Скорость индексации в Рамблере гораздо ниже, чем рассмотренных выше ПС. Так что не удивляйтесь, если Вашего проекта долгое время не будет в индексе этого поисковика.

Поскольку данная система уже давно перестала развивать свой поиск, то и от аддурилки проку никакого. Так куда стучаться, чтобы произошла индексация сайта в rambler? Если Вы уже добавились в Яндекс, то стучаться больше никуда не нужно, так как в Рамблер интегрирована поисковая база Yandex.

Индексация в mail.ru

Поисковая система майл ру также имеет в своем арсенале кабинет вебмастера, где и можно добавить ресурс в систему. Другой способ добавления вебсайта на индексацию mail – это напрямую зайти по адресу: http://go.mail.ru/addurl.

Система майл стала активно развивать свой поиск и различные сервисы, в том числе и инструменты для вебмастеров, поэтому чтобы оставить заявку на индексацию сайта в mail ru следует завести свой аккаунт.

Индексация в Nigma

Нигма интеллектуальная поисковая система разработанная в России пытается всунуться и отхватить долю Рунета. В данный момент она смогла отвоевать порядка 3 млн запросов в сутки. Делаем вывод, что отмахиваться от данного поисковика не стоит, а потому вот ссылка, по которой можно добавить ресурс на индексацию в Нигму: http://www.nigma.ru/index_menu.php?menu_element=add_site.

Индексация сайта Yahoo

Поисковая система yahoo принадлежит к тем поисковикам, что первыми стали покорять просторы Интернета. Она знакома пожалуй всем и каждому, кто мало мальськи связан с глобальной сетью. Добавить проект на индексацию в Яхоо: http://search.yahoo.com/info/submit.html.

Индексация сайта в Bing

Бинг поисковая система является детищем Майкрософта и пришла на замену Live Search. По заявлениям представителей Microsoft Bing гораздо эффективнее предшественника и он готов составить конкуренцию Гугл. Так ли это покажет время. Но трафик с данного поисковика есть, а значит добавлять сайт на индексирование необходимо: http://www.bing.com/toolbox/submit-site-url.

Чем отличается индексация в Google и Яндекс?

Индексация сайта в Google

Когда мы гуглим что-то, поиск данных ведется не по сайтам в режиме реального времени, а по индексу Google, в котором хранятся сотни миллиардов страниц. Во время поиска учитываются разные факторы ― ваше местоположение, язык, тип устройства и т. д.

В 2019 году Google изменил свой основной принцип индексирования сайта — вы наверняка слышали о запуске Mobile-first. Основное отличие нового способа в том, что теперь поисковик хранит в индексе мобильную версию страниц. Раньше в первую очередь учитывалась десктопная версия, а теперь первым на ваш сайт приходит робот Googlebot для смартфонов — особенно, если сайт новый. Все остальные сайты постепенно переходят на новый способ индексирования, о чем владельцы узнают в Google Search Console.

Еще несколько основных отличий индексации в Google:

- индекс обновляется постоянно;

- процесс индексирования сайта занимает от нескольких минут до недели;

- некачественные страницы обычно понижаются в рейтинге, но не удаляются из индекса.

В индекс попадают все просканированные страницы, а вот в выдачу по запросу — только самые качественные. Прежде чем показать пользователю какую-то веб-страницу по запросу, поисковик проверяет ее релевантность по более чем 200 критериям (факторам ранжирования) и отбирает самые подходящие.

Индексация сайта в Яндекс

В Яндексе процесс индексирования в целом такой же. Поисковые роботы заходят на сайт, загружают и обрабатывают данные, после чего добавляют их в индекс для дальнейшего использования в выдаче.

Что еще важно знать про индексацию в Яндекс:

- индекс Яндекса обновляется во время обновлений поисковой базы (примерно раз в три дня);

- процесс индексирования сайта занимает от недели до месяца;

- Яндекс работает медленнее, чем Гугл, но при этом удаляет некачественные страницы из индекса, отбирая только полезные материалы.

В выдачу Яндекса попадают те страницы, которые максимально отвечают на поисковый запрос, содержат понятную и полезную информацию и удобны в использовании.

Что поисковые роботы делают на вашем сайте, мы разобрались, а вот как они попадают туда? Существует несколько вариантов.

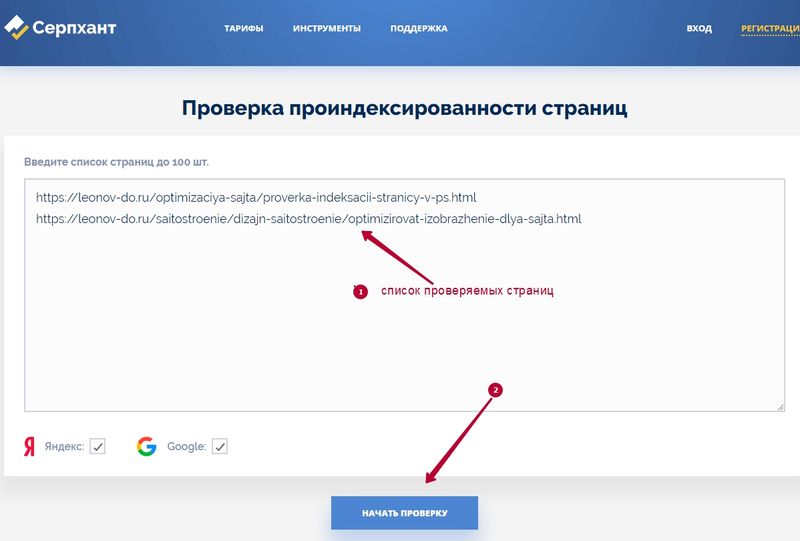

Серпхант

Недавно открыл для себя интересный онлайн сервис с помощью которого можно проверить индексацию страницы. Все очень просто, вводите списком ссылки на необходимые страницы и нажимаете кнопку Начать проверку.

Проверка индексации сервисом Серпхант

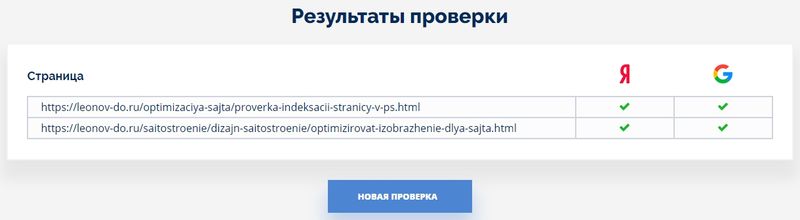

По истечению непродолжительного времени вым выдаются результаты проверки индексации в Яндексе и Google запрошенных страниц.

Результат проверки индексации

Описанный способ наверное самый простой и быстрый чтобы проверить индексацию страницы.

Я описал способы, которыми пользуюсь сам для быстрой проверки индексации страницы в поисковых системах. На самом деле похожих сервисов довольно много, есть бесплатные и платные, хорошие и не очень.

В данной статье я специально не упомянул сервисы Вебмастера от Яндекс и Google. У каждого из перечисленных поисковиков есть свой инструментарий, который дает полную картину о сайте, но чтобы ими воспользоваться ты должен быть хозяином сайта, а вышеперечисленные методы подходят абсолютно для любого сайта, будь он чужим или своим.

Дмитрий Леонов | leonov-do.ru