Индексирование сайта. рассказываем, как добавляться в поисковые системы, и отвечаем на важные вопрос

Содержание:

- Индексация сайта в Google и Яндекс

- Как индексирует сайты Гугл и Яндекс

- Как закрыть сайт от индексации

- Индексация страницы

- Определение

- Что такое индексация обратных ссылок

- Дублирование

- Как подготовить сайт к индексации?

- Используем панель Вебмастера

- Зачем нужна индексация?

- Способы проверки индексации сайта

- Сколько ждать попадания в индекс?

- Типы роботов поисковых систем

- Как Гугл и Яндекс проверяют страницы на качество

- Как работает инструмент проверки индексации

Индексация сайта в Google и Яндекс

Принципы индексации у этих поисковых систем преимущественно одинаковые: краулинг → очистка → индексация → ранжирование. Но различия можно найти, поэтому расскажем о тех, которые известны.

Индексация в Google

Самое главное отличие — Google лучше ориентируется в англоязычном сегменте, то есть лучше воспринимает текст и запрос пользователя на английском. Разница на момент 2020, думается, незначительная, но учитывать стоит.

У Гугла 2 основных типа роботов: для мобильных сайтов и для десктопных. Новые сайты индексируются мобильными роботами и приоритет отдан мобильным версиям сайта, согласно алгоритму mobile-first индекс.

Скорость индексации обычно выше, чем у Яндекса: на 1 страницу уходит неделя или меньше. Индекс обновляется постоянно, а некачественные страницы не удаляются из него, но при этом и не показываются пользователям.

Индексация в Яндексе

У Яндекса тоже 2 типа роботов: основной и быстрый (Orange). Основной робот занимается индексацией всего интернета, а быстрый отвечает за поиск самых свежих документов, чтобы информация была доступна как можно быстрее (от нескольких минут до пары секунд).

Обновление индекса происходит раз в несколько дней ночью, когда нагрузки на серверы меньше. Процесс индексирования сайта обычно занимает от недели до месяца, а некачественные страницы удаляются из индекса.

Как проверить индексацию?

Уточним сразу пару моментов. Индексацию нужно проверять как в Google, так и в Яндексе. Более того, вы должны знать изначальное количество страниц на сайте. Это можно сделать с помощью краулеров типа Xenu, Screaming Frog, Netpeak Spider и других.

Как проверить индексацию:

- Инструменты Яндекс Вебмастер и Google Search Console. В Вебмастере это Индексирование → Страницы поиска (отдельные страницы смотрите в инструменте «Проверить статус URL»). В Search Console откройте отчёт Покрытие → Страницы без ошибок (индексацию отдельных страниц ищите в Проверке URL).

- Используйте оператор site. В поисковой строке Яндекса и Google введите site:name.com, где name — домен сайта. Под строкой поиска справа будет указано количество проиндексированных страниц. Если разница в количестве больше 10%, у вас проблемы с индексацией.

- RDS Bar и другие сервисы. RDS Bar — это бесплатный плагин для браузера. В нём вы узнаете не только количество проиндексированных страниц, но и получите другую полезную информацию. Также автор статьи советует воспользоваться сервисом a.pr-cy. Он позволяет провести хороший первичный аудит сайта и уже в самом начале выявить основные проблемы.

Как индексирует сайты Гугл и Яндекс

Яндекс и Гугл, пожалуй, самые популярные поисковики в России. Чтобы поисковые системы проиндексировали сайт, о нем нужно сообщить. Сделать это можно двумя способами:

- Добавить сайт на индексацию при помощи ссылок на других ресурсах в интернете — этот способ считается оптимальным, так как страницы, найденные таким путем, робот считает полезными и их индексирование проходит быстрее, от 12 часов до двух недель.

- Отправить сайт на индексацию путем заполнения специальной формы поисковой системы вручную с использованием сервисов Яндекс.Вебмастер, Google Webmaster Tools, Bing Webmaster Tools и др.

Второй способ медленнее, сайт встает в очередь и индексируется в течение двух недель или больше.

В среднем, новые сайты и страницы проходят индексацию за 1–2 недели.

Считается, что Гугл индексирует сайты быстрее. Это происходит потому, что поисковая система Google индексирует все страницы — и полезные, и неполезные. Однако в ранжирование попадает только качественный контент.

Яндекс работает медленнее, но индексирует полезные материалы и сразу исключает из поиска все мусорные страницы.

Индексирование сайта происходит так:

- поисковый робот находит портал и изучает его содержимое;

- полученная информация заносится в базу данных;

- примерно через две недели материал, успешно прошедший индексацию, появится в выдаче по запросу.

Есть 3 способа проверки индексации сайта и его страниц в Гугл и Яндексе:

- при помощи инструментов для вебмастеров — google.com/webmasters или webmaster.yandex.ru;

- при помощи ввода специальных команд в поисковую строку, команда для Яндекс будет выглядеть так: host: имя сайта+домен первого уровня; а для Гугл — site: имя сайта+домен;

- с помощью специальных автоматических сервисов.

Как закрыть сайт от индексации

Закрыть сайт от индексации — запретить поисковым роботам доступ к сайту, к некоторым его страницам, части текста или изображению. Обычно это делается для того, чтобы скрыть от публичного доступа секретную информацию, технические страницы, сайты на уровне разработки, дублированные страницы и т. п.

Сделать это можно несколькими способами:

При помощи robots.txt можно запретить индексацию сайта или страницы. Для этого в корне веб-сайта создается текстовый документ, в котором прописываются правила для роботов поисковых систем. Эти правила состоят из двух частей: первая часть (User-agent) указывает на адресата, а вторая (Disallow) запрещает индексацию какого-либо объекта.

Например, запрет индексации всего сайта для всех поисковых ботов выглядит так:

User-agent: *

Disallow: /

При помощи мета-тега robots, что считается наиболее правильным для закрытия одной страницы от индексирования. При помощи тегов noindex и nofollow можно запретить роботам любых поисковых систем индексировать сайт, страницу или часть текста.

Запись для запрета индексации всего документа будет выглядеть так:

<meta name=»robots» content=»noindex, nofollow»/>

Можно создать запрет для конкретного робота:

<meta name=»googlebot» content=»noindex, nofollow»/>

Индексация страницы

Когда Яндекс и Гугл уже познакомились с сайтом и «приняли» его в свою поисковую базу, боты будут возвращаться на ресурс, чтобы сканировать новые, добавляющиеся материалы. Чем чаще и регулярнее будет обновляться контент, тем более пристально будут следить за этим пауки.

Когда ресурс хорошо проиндексировался, выводить в поиск отдельные, новые страницы уже гораздо проще. Но тем не менее далеко не всегда анализ происходит равномерно и с одинаковой скоростью для всех, одновременно обновленных html-документов. Всегда выигрывают наиболее посещаемые и раскрученные категории ресурса.

Определение

Представьте, что сайт – это документ или несколько документов с информацией. Поисковая система – сборник таких документов, работающий по определенным правилам. Он помогает пользователям в кратчайшие сроки найти документ с нужной информацией. Для этого необходимо проверить каждый документ, посмотреть, какого рода в нем информация, после чего разместить его где-то относительно других документов. Это и есть индексация.

Роботы приходят, сканируют весь контент, если все хорошо, – контент заносится в поисковые базы и начинает ранжироваться относительно других проектов.

После этого материалы попадают в поисковую выдачу. Позиция в поисковой выдаче может зависеть от качества материалов, самого ресурса, технической и внешней SEO-оптимизации и других факторов.

Поисковые системы заинтересованы в том, чтобы их пользователи получали качественные материалы в выдаче. По этой причине поисковая оптимизация претерпела очень много изменений за последние годы.

Раньше вебмастеры старались угодить роботам, делая свои проекты максимально “удобными” для индексации. Сейчас же роботы научились отличать “сеошный” бесполезный контент, от качественного и адекватного.

Поэтому для хорошей индексации не хватит простой SEO-оптимизации. Нужно понимать, что сейчас поисковые системы отдают предпочтение ресурсам с хорошими поведенческими факторами. Их можно добиться только при разработке проекта для людей.

За переоптимизацию или создание некачественного бесполезного контента ресурс может попасть под санкции. Это может включать в себя как простое снижение приоритета, так и полный запрет индексации со стороны поисковиков – материалы проекта удаляются из поисковых баз данных и больше никогда туда не попадают.

У каждой поисковой системы есть свои правила. В большинстве своем они почти ничем не отличаются, поэтому вебмастеры стараются оптимизировать свои проекты сразу и для всех.

Что такое индексация обратных ссылок

Индексация обратных ссылок — процесс добавления их в базу поисковых систем. Когда роботы Яндекса и Гугла обнаруживают новый контент, они сканируют его и через некоторое время страница появляется в выдаче.

Несколько лет назад поисковики индексировали контент гораздо медленнее, чем сейчас. Особенно ярко выраженной проблема была в Яндексе. Вебмастера неделями ждали апдейтов, чтобы новые страницы попали в базу поисковой системы и начали набирать вес.

В 2021 году таких проблем нет — если сайт хорошо оптимизирован по технической части и регулярно публикует контент, новые адреса быстро попадают сначала в быструю выдачу, а затем в основную.

С бэклинками не все так просто — они индексируются гораздо дольше. При покупке ссылок напрямую есть риск остаться ни с чем. К примеру, если на сайте вебмастера проблемы с файлом robots.txt или неправильно настроен тег meta robots, ничего сделать не получится. Придется ждать, пока владелец проекта выйти на связь и разберется с ошибками.

Проблемы с индексацией ссылок на авторитетных сайтах возникают редко. Если контент регулярно обновляется и быстробот добавляет новые страницы в индекс, Google и Яндекс быстро обнаруживают проставленные ссылки и индексируют их.

Скорость появления бэклинков в консолях для вебмастеров зависит от многих факторов, поэтому нельзя однозначно сказать, когда ссылка начнет учитываться поисковиками. При наличии технических проблем у поисковых систем процесс обновления ссылочного профиля может затянуться надолго.

Часто бывает так, что при проверке сторонними сервисами находится гораздо больше бэклинков, чем в Google Search Console и Яндекс.Вебмастер. Это нормальная ситуация, но линки с основных ресурсов должны быть видны во всех источниках.

Факторы, которые влияют на индексацию ссылок

Опытные SEO-специалисты и вебмастера знают главное правило линкбилдинга: «Ссылки с трастовых и релевантных ресурсов на вес золота». Обычно с такими бэклинками не возникают проблемы, они быстро индексируются и приносят профит в виде хороших позиций. Особенно важна скорость индексации обратных ссылок при продвижении новых сайтов.

Что касается появления ссылки в консолях для вебмастеров, то данные могут обновляться с задержкой. Часто бэклинки пропадают из списка, а потом снова появляются. Это естественный процесс, на нём не стоит зацикливаться.

Факторы, влияющие на индексацию ссылок:

- Качество донора. Чем авторитетнее сайт в глазах поисковых систем, тем быстрее индексируются страницы и обратные ссылки. Как же проверить качество и траст донора, читайте в статье.

- Правильность размещения. Неактивные ссылки и URL, ссылающиеся на неосновное зеркало, могут не появиться в консолях для вебмастеров.

- Частота обновления контента. Ссылки с новостных проектов и других ресурсов с непрерывным процессом обновления информации индексируются гораздо быстрее.

- Техническое состояние. Если сайт часто падает, некорректно настроены каноникалы или страницы отдают неправильный код, могут возникнуть проблемы с попаданием линков в базу поисковых систем.

- Стабильность поисковиков. При глобальных обновлениях алгоритмов или масштабных изменениях в Google Search Console или Яндекс.Вебмастер новый контент может индексироваться с задержкой.

Если закупаете ссылки на качественных проектах и придерживаетесь четкого плана по линкбилдингу, проблем с индексацией и учетом бэклинков не будет. Следите за ситуацией, но в разумных пределах. Нет смысла несколько раз в день заходить в консоли для вебмастеров и обновлять страницу с внешними ссылками.

Дублирование

Подразумевает наличие нескольких идентичных страниц одного сайта, в которых содержится одинаковый контент.

Виды дублей:

-

страницы, адрес которых различается знаком «/». Например, «www.primer_saita.ru/Tovar/cart/GM928» и абсолютно аналогичный «…/GM928/». Часто встречается такая ситуация с карточкой одного и того же товара, которая относится к разным категориям (коньки, подходящие, как для девочек, так и для мальчиков);

-

дубли-страницы с незначащими параметрами, которые не воспринимает робот-поисковик. Примеры некоторых незначащих элементов для робота-поисковика, можно увидеть ниже:

Неприятности, которые могут возникнуть из-за дублей:

-

бот поисковой системы, вместо индексации необходимого и корректного адреса может посещать и анализировать множество ненужных страниц;

-

в базу данных поиска робот-анализатор может включить только одну страницу из всех возможных дублей, опираясь на свое усмотрение.

Как бороться с дублированными страницами:

Прописать атрибут rel= «canonical» тега со своим значением, то есть «выделить» страницу, расставив «приоритеты» цепочкой. Например, есть две страницы:

Допустим, что предпочитаемый адрес, который нам нужен – это вторая ссылка. Тогда, в первой странице необходимо прописать в ее html-коде следующую строчку:

Важно! Алгоритм анализа поисковым роботом устроен таким образом, что не считает данную директиву строгой, поэтому бот рассматривает ее, как предполагаемый вариант, который может быть проигнорирован!

-

«редирект 301», о котором мы уже говорили ранее. Особенно актуален в случаях дублей страниц с «/» и без него;

-

В файле robots.txt прописать параметры «disallow» (запрет доступа) и «clean-param» (учитывание динамических параметров (id сессий и др.), не влияющие на содержимое страницы). Пример таких дублей мы рассмотрели чуть ранее.

Где можно выявить дубли? Все в том же Вебмастере. В сервисе от «Яндекса» заходим в раздел «Индексирование», затем «Проверить статус URL», вводим ссылку, анализируем результат.

Как подготовить сайт к индексации?

Сразу стоит отметить, что крайне нежелательно выкладывать сайт на стадии разработки. Поисковые системы могут проиндексировать неоконченные страницы с некорректными сведениями, орфографическими ошибками и т. д. В итоге это негативно отразится на рейтинге сайта и выдаче информации с этого ресурса в поиске.

Теперь давайте перечислим моменты, о которых нельзя забывать на этапе подготовки ресурса к индексации:

- на flash файлы распространяются ограничения индексации, поэтому сайт лучше создавать с помощью HTML;

- такой тип данных, как Java Script также не индексируется поисковыми роботам, в связи с этим навигацию по сайту следует дублировать текстовыми ссылками, а всю важную информацию, которая должна быть проиндексирована, не пишем в Java Script;

- нужно убрать все неработающие внутренние ссылки так, чтобы каждая ссылка вела на реальную страницу вашего ресурса;

- структура сайта должна позволять с легкостью переходить от нижних страниц к главной и обратно;

- лишние и второстепенные сведения и блоки лучше переместить к низу страницы, а также скрыть их от ботов специальными тегами.

Используем панель Вебмастера

Каждая поисковая система имеет свою панель инструментов, специально предназначенную для вебмастеров. С помощью этой панели можно увидеть общее количество проиндексированных страниц. Рассмотрим на примере самых популярных ПС (Яндекс и Google), как выполнять такую проверку.

Чтобы использовать панель инструментов Яндекс в данном контексте, нужно завести аккаунт (если его еще нет), зайти в панель и добавить в нее свой сайт. Там будет показано общее количество страниц, которые уже проиндексированы.

Для использования панели инструментов Google также нужно обзавестись аккаунтом, чтобы иметь возможность зайти в панель. В нее нужно добавить свой сайт и зайти на вкладку «Состояние / Статус индексирования». Здесь также будет показано количество проиндексированных страниц.

Нередко можно заметить, что панель Вебмастера Google может показать значительно большее количество проиндексированных страниц, чем панель инструментов Яндекс. Представим, что на сайте 70 уникальных страниц, которые проиндексировались. И, скажем, Яндекс насчитал приблизительно такое количество ссылок, а Гугл, например, 210. Получается, что Яндекс показал правильное число, а Гугл в 3 раза больше. Так в чем же дело? А дело в дублях страниц, генерируемых движком WordPress. Такие дубли поисковикам не по душе. Использование robots.txt позволяет игнорировать индексацию дублей страниц поисковыми системами. И если на Яндекс это действует, то с Гуглом в этом плане могут возникать проблемы, так как он может действовать по своему усмотрению.

Есть также специальный сервис Pr-cy.ru, позволяющий получить вебмастерам различные данные по сайтам – в том числе, число страниц, проиндексированных в Гугле и Яндексе. Чтобы узнать эту информацию, нужно посмотреть на две нижние колонки соответствующих поисковых систем.

Что помогает ускорить индексацию сайта

Чтобы страницы быстрее индексировались, нужно придерживаться главных правил:

Регулярное размещение уникальных и оптимизированных статей. Поисковый робот возьмет себе за привычку регулярно посещать тот сайт, на котором с определенной периодичностью размещается качественный, полезный и интересный контент.

Анонсирование о размещении нового контента или полезных обновлениях на сайте через социальные сети. После того, как появилась статья, можно самостоятельно сообщить об этом в социальную сеть с помощью кнопки retweet. Поисковый бот отметит это и зайдет на сайт через социальную сеть значительно быстрее.

Поисковому роботу гораздо проще найти конкретную страницу с помощью ссылки, имеющейся на вашем сайте

То есть, не стоит забывать о важности внутренней перелинковки.

Добавив xml-карту в панель вебмастера, мы даем возможность поисковому боту пройти по ней. Также ее нужно добавить в robots.txt

Полезна и карта сайта (карта для человека), по которой бот отыщет все страницы сайта.

В материале мы рассмотрели основные способы, позволяющие проверить, попали ли страницы сайта в индекс различных поисковых систем. Некоторые из них более эффективные, а какие-то – менее, но каждый из них имеет право на существование и использование.

Читайте далее:

Seo – проверка индексации текста и веса ссылок тест

Методы ускорения индексации сайта в яндексе

Быстрая индексация сайта в Гугле

Проверить картинки на уникальность

Популярные бесплатные CMS системы

Как скрыть персональные данные в поисковых системах?

Зачем нужна индексация?

Индексация — очень важный процесс на этапе раскрутки сайта. Своевременно выполненная, она позволяет решить сразу несколько задач:

- занять достойное место в поисковиках;

- привлечь поисковый трафик на ресурс;

- привлечь партнеров для обмена ссылками, а магазинам – клиентов;

- улучшить поведенческий фактор (работает, если контент на сайте по-настоящему полезный, а не состоящий из абракадабры);

Кроме того, боты при индексации могут выявить нарушения правил действующих поисковиков и применить меры. Например, заблокировать ресурс или отправить его под фильтр, тем самым немного снизив конкуренцию в Сети.

Способы проверки индексации сайта

Предлагаем вашему вниманию 4 самых распространенных и простых способа, позволяющие проверить, какие страницы есть в индексе, а какие – нет.

1. Через панель вебмастера

Этим методом владельцы веб-ресурсов проверяют их наличие в поиске чаще всего.

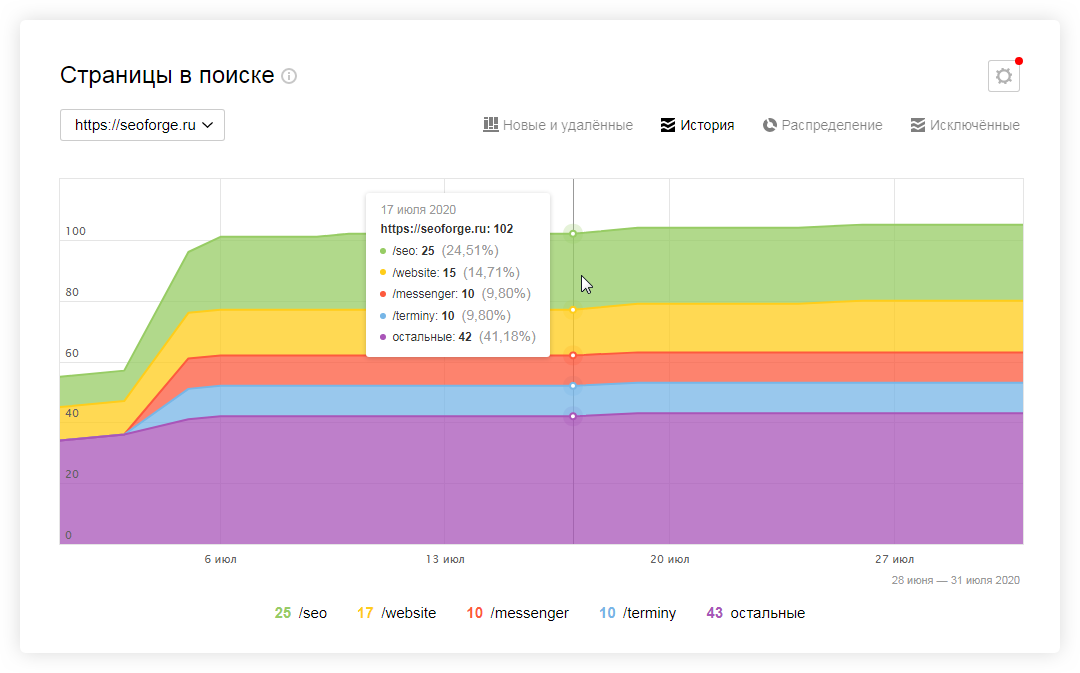

Яндекс

- Авторизуйтесь в Яндекс.Вебмастер.

- Перейдите в меню «Индексирование сайта».

- Под ним найдите строку «Страницы в поиске».

Можно пойти и по другому пути:

- Выберите «Индексирование сайта».

- Дальше перейдите в «История».

- Затем кликните на вкладку «Страницы в поиске».

И первым, и вторым способом вы сможете изучить динамику роста или спада числа страниц в поисковой системе.

- Зайдите в панель управления сервиса .

- Кликните на вкладку Search Console.

- Перейдите в «Индекс Google».

- Нажмите на опцию «Статус индексирования».

2. Через операторов поисковых систем

Они помогают уточнить результаты поиска. Так, применение оператора «site» позволяет увидеть приблизительное число страниц, которые уже находятся в индексе. Чтобы проверить этот параметр, в строке поиска Яндекс либо Google укажите: «site:адрес_вашего_сайта».

Важно! Если результаты в Google и Яндекс сильно разнятся между собой, то значит ваш сайт имеет какие-то проблемы со структурой сайта, мусорными страницы, индексацией или на него наложены санкции. Для поиска вы также можете использовать дополнительные инструменты, например, чтобы узнать, как изменялась индексация страниц за определенный период времени

Для этого под поисковой строкой нажмите на вкладку «Инструменты поиска» и выберите период, к примеру, «За 24 часа»

Для поиска вы также можете использовать дополнительные инструменты, например, чтобы узнать, как изменялась индексация страниц за определенный период времени. Для этого под поисковой строкой нажмите на вкладку «Инструменты поиска» и выберите период, к примеру, «За 24 часа».

3. Посредством плагинов и расширений

Используя специальные программы, проверка индексации веб-ресурса произойдет автоматически. Это можно сделать с помощью плагинов и расширений, еще известных как букмарклеты. Они представляют собой javascript-программы, которые сохраняются в браузере в виде стандартных закладок.

Преимущество плагинов и расширений в том, что вебмастеру нет необходимости каждый раз по новой заходить в поисковик и вводить там адреса сайтов, операторы и прочее. Скрипты произведут все в автоматическом режиме.

Самым популярным плагином, применяемым в этих целях, является RDS bar, который можно скачать в магазине приложений любого браузера.

Стоит отметить, что в Mozilla Firefox у плагина куда больше возможностей, чем в других браузерах. RDS bar предоставляет информацию относительно и всего веб-сайта, и его отдельных страниц

На заметку. Есть платные и бесплатные плагины. И самый большой минус бесплатных плагинов в том, что в них регулярно нужно вводить капчу.

Нельзя оставить без внимания и букмарклет «Проверка индексации». Чтобы включить программу, просто перетяните ссылку на панель браузера, а затем запустите свой портал и нажмите на закладку расширения. Так вы откроете новую вкладку с Яндекс или Google, где изучите нужную информацию касательно индексации определенных страниц.

4. С помощью специальных сервисов

Я в основном пользуюсь сторонними сервисами, потому что в них наглядно видно какие страницы в индексе, а какие там отсутствуют.

Бесплатный сервис

https://serphunt.ru/indexing/ — есть проверка, как по Яндекс, так и по Google. Бесплатно можно проверить до 50 страниц в сутки.

Платный сервис

Из платных мне больше всего нравится Topvisor — стоимость 0.024р. за проверку одной страницы.

Вы загружаете в сервис все страницы вашего сайта и он вам покажет, какие находятся в индексе поисковых систем, а какие нет.

Сколько ждать попадания в индекс?

В индекс Google новый сайт залетает в среднем спустя неделю. В Яндексе — это может занимать до двух недель. Эти сроки актуальны, если на сайте не создано никаких препятствий для обхода поисковыми роботами

Важно понимать, попадание в индекс не означает, что страницы со старта получат высокие позиции в поиске. В первое время, скорее всего, они будут на задворках выдачи — на второй-третьей странице

И только постепенно начнут укреплять свои позиции. Также они могут вовсе не отображаться по основным поисковым запросам (находясь при этом в индексе). Второй сценарий больше актуален для молодых сайтов, пребывающих в песочнице.

Типы роботов поисковых систем

Процессы поисковых систем основаны на работе четырех типов основных поисковых роботов:

- Основной индексирующий робот;

- Робот, индексирующий изображения;

- Робот, изучающий зеркала сайта;

- Робот, контролирующий работоспособность страниц сайта и сайта в целом.

Вы можете контролировать, вернее, быть в курсе, какой робот зашел к вам на сайт. Для этого есть специальные лог-файлы посещений. Доступны эти файлы в административной панели сервера (хостинга) или по FTP. Например,

- Основной индексирующий робот Яндекс: YandexBot/3.0; +http://yandex.com/bots;

- Бот Mail: Mail.RU_Bot/2.0; +http://go.mail.ru/help/robots.

- В журнале посещений, вы увидите боты в таком обозначении: «Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) – это бот Bing.

Кроме четырех перечисленных , выше, типов роботов, есть и другие индексирующие роботы:

- Индексирующие видео и иконки (пиктограммы) сайтов;

- Робот, контролирующий доступность (работоспособность) сайтов;

- Индексатор «быстрой» информации, на новостных площадках Яндекс. Новостей и т.п.

На этом все! Эта небольшая статья, не может охватить все детали, и процессы поисковых систем требует более глубокого изучения.

SeoJus.ru

Как Гугл и Яндекс проверяют страницы на качество

Чтобы сайты прошли индексацию, о них нужно рассказать. Делается это двумя методами:

- Оставить ссылку на схожих по тематике сайтах. Это самый приемлемый вариант, ведь если информация о портале будет содержаться на других платформах, то боты посчитают его полезным и быстрее проиндексируют: от 12 часов до 2 недель.

- Заполнить специальную анкету, используя инструменты Яндекс.Вебмастер, Google Webmaster Tools и другие. Индексация здесь происходит медленнее, так как ресурс находится в очереди и может простоять в ней от 2 недель и больше.

Seo-специалисты считают, что Гугл справляется со своей задачей значительно быстрее, так как эта поисковая система индексирует страницы без разбора: как полезные, так и бесполезные. Тем не менее ранжируются только качественные сайты.

С другой стороны, Яндекс работает медленнее, но лучше отбирает ресурсы, содержащие полезный контент, отсеивая “мусор”.

Как происходит индексация:

- поисковый бот заходит на сайт и анализирует его содержимое;

- все данные вносятся в базу данных;

- приблизительно через 2 недели информация, которая прошла индексацию, появляется в выдаче.

Как работает инструмент проверки индексации

Шаг 1. Добавление URL

Перейдите на страницу инструмента и добавьте URL, индексацию которых необходимо проверить. Сделать это можно тремя способами:

Добавление XML-карты сайта (способ подходит, если вам нужно проверить все URL сайта; для этого укажите полный путь к карте сайта в формате http://www.site.ru/sitemap.xml).

Загрузка XLSX-файла (в этом случае система проверит все URL, указанные на первом листе сайта; расположение URL по столбцам и строкам не имеет значения).

Добавление списка URL вручную (способ подходит, если вам нужно проверить не все URL сайта, а только некоторые из них; каждый URL указывайте с новой строки).

В зависимости от того, из какого источника вы будете брать URL, решаются разные задачи:

Из XML-карты сайта или CMS. В этом случае можно проверить, какие из важных URL не проиндексированы.

Пример. В карте сайта 1250 URL, которые подлежат индексации. Мы вводим поочередно в Яндексе и Google команду:

site:yourdomain.ru

Получаем количество проиндексированных страниц — 684 и 1090.

Задача — определить, каких страниц не хватает. Сканируем XML-карту сайта с помощью инструмента от PromoPult, получаем информацию по всем URL и выявляем несоответствия.

Как ускорить индексацию сайта: 5 способов на все случаи жизни

Из отчета о проиндексированных страницах из Яндекс.Вебмастера или Google Search Console. Бывает, что в каком-то поисковике количество проиндексированных страниц превышает количество URL в карте сайта. В такой ситуации необходимо загрузить на проверку все URL из поисковика, в котором наблюдается такое превышение, — это позволит выявить «лишние» страницы.

Пример. В карте сайта 15 570 URL, которые подлежат индексации. Проверяем количество страниц по команде site:yourdomain.ru в Яндексе и Google:

В Яндексе количество страниц превышает количество страниц не только в Google, но и в карте сайта. Очевидно, что в индекс попали нежелательные страницы. Если запустить проверку только по URL из карты, то мы так и не узнаем, какие URL «лишние». Поэтому переходим в Яндекс.Вебмастер, выгружаем все страницы из поиска и проверяем их. Теперь проще разобраться, в чем проблема.

Чтобы не было проблем с индексацией, запустите продвижение сайта в комплексном SEO-модуле системы PromoPult. Внутренняя оптимизация, повышение авторитетности сайта, наполнение контентом — все это специалисты делают за вас. Вы лишь задаете бюджет и контролируете процесс.

На данном этапе нужно выбрать ПС для проверки индексации. Для выявления расхождений выбирают обе системы.

Шаг 3. Получение результата

После завершения проверки отчет появится в «Списке задач». Кроме того, вам на почту придет уведомление:

Скачать отчет можно в формате XLSX:

В файле 2 листа: результаты анализа и исходные данные. На первом листе 3 столбца: URL и данные по индексации (1 — страница проиндексирована, 0 — нет).

С помощью автофильтра вы легко определите, каких страниц нет в той или иной ПС: